Skrivandet räcker inte för roboten

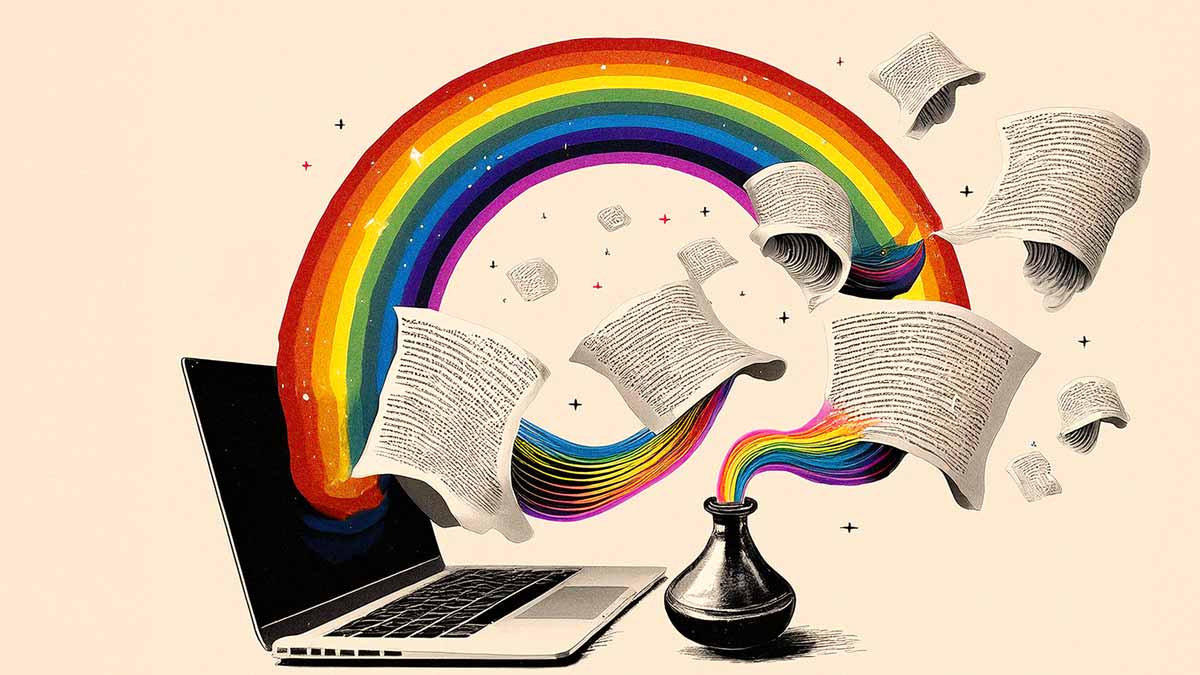

Förmågan att skriva slog världen med häpnad. Men är chattroboten Chat GPT ändå inte mer än en ande i flaskan?

När filosofen och kognitionsforskaren David Chalmers senaste bok Virtuella världar släpptes anordnades en paneldebatt på Lilla Cirkus i Stockholm. Där diskuterades några av bokens centrala teman, nämligen artificiella och fysiska världar, samt mänskligt och artificiellt medvetande. I samtalet framgick att företrädare för både industri och forskning är förvånade över hur snabbt en AI-applikation som Chat GPT har utvecklats och hur väl den kan generera mänskligt språk.

Vid det här laget har nog många hört talas om Chat GPT:s förmåga att snabbt generera olika typer av texter, men också att en effektiv användning kräver träffsäkra instruktioner av användaren. Kravet på faktagranskning är också stort eftersom applikationen av olika skäl inte alltid framställer sanningsenliga fakta.

Då Chat GPT bygger på vad som kallas artificiell intelligens, AI, så har den senaste tidens snabba utveckling gjort att förutsägelser tidigarelagts gällande hur snart AI kan tillskrivas medvetande. David Chalmers spekulerade under samtalet att en medveten AI skulle kunna vara möjlig redan inom 20 år, i kontrast mot hans tidigare förutsägelser som har varit mycket mer försiktiga.

Panelen på Lilla Cirkus diskuterade de politiska och sociala implikationerna av ett artificiellt medvetande, men frågan om vad som faktiskt kan räknas som ett sådant lämnades mestadels obesvarad. Och här står språkförmågan i centrum.

Även om det till viss del är oklart hur en applikation som Chat GPT faktiskt går till väga för att kunna producera människoliknande tal i skrift, så pekar den snabba utvecklingen på att förmågan att förutse nästa ord är avgörande för applikationens framgång. En paneldeltagare föreslog att det kanske inte behövs mer än så för att kunna producera språk, och att en förmåga att förutse vad som kommer härnäst skulle gå att likställa med intelligens och medvetande, både för människor och AI.

Men det finns problem med den synen på artificiell intelligens. Några av dessa problem har att göra med hur vi definierar språk och vilket förhållande språket kan tänkas ha till medvetandet. Det är uppenbarligen möjligt att tala – i bemärkelsen att producera språkliga yttranden i form av text – utan att vara medveten. Det är vad Chat GPT gör. Den kan producera oändliga mängder text utan att egentligen förstå vad den själv säger.

Men det är också möjligt att vara medveten utan att kunna tala. Olika beskrivningar av komaliknande tillstånd där patienten är medveten men oförmögen att kommunicera är ett exempel på detta. Vi vill också veta om djur är medvetna. Vi har goda skäl att tro det, men eftersom de inte kan tala så har vi svårt att bedöma om de är det.

Problemet med båda scenarierna är att det är svårt att bedöma graden av medvetenhet utifrån några andra parametrar än språklig kommunikation. Graden av medvetenhet hos en komatös patient går bara att bedöma efter att patienten har kommit ur koman och kan berätta om sin upplevelse. Språkförmåga kan därmed inte likställas med medvetenhet även om medvetenhet bara kan bedömas med hjälp av språk. Trots detta så är språkförmågan en avgörande komponent i debatten om AI:s eventuella medvetenhet och vilka konsekvenser det kommer ha för oss människor.

”Ett sofistikerat verktyg för att uppdatera vår egen och andras kunskap om världen”

Vad är då språket, som har en sådan central roll i debatten om artificiell intelligens och medvetande? Det finns flera modeller för hur språket kan definieras, men den dominerande skulle kunna beskrivas som informationsöverföringsmodellen. Den beskriver språk som ett sofistikerat verktyg för att uppdatera vår egen och andras kunskap om världen och för att kunna redogöra för våra upplevelser gentemot våra artfränder. Samma modell kan även appliceras på andra djurarters kommunikation – även om språk alltid framhålls som en speciell form av kommunikation som är reserverad för människor.

Enligt informationsöverföringsmodellen kan yttranden delas in i grammatiska och ogrammatiska yttranden, det vill säga yttranden som betyder något och sådana som inte gör det. Att Chat GPT är så bra på att producera yttranden som betyder något (det vill säga grammatiska yttranden) är det som fascinerar oss och det som gör oss benägna att tillskriva applikationen någon form av intelligens och – om några år – kanske även medvetande.

Språk som informationsöverföringsverktyg är dock inte den enda möjliga modellen för att definiera språk. En sådan modell har dessutom flera tillkortakommanden som gör att man kan ifrågasätta dess giltighet. Dom flesta lingvister anser nämligen att språk är mer än informationsöverföring.

Om man antar en funktionalistisk syn på språk där form följer funktion, så är informationsöverföring bara en av flera språkfunktioner. Helt kort så innebär en funktionalistisk syn på språk att språkanvändning ger upphov till språkstruktur, snarare än att sådan struktur skulle vara förprogrammerad i det mänskliga psyket. Ända sedan lingvistpionjären Roman Jakobson presenterade sin syn på språkets funktioner på 1960-talet, så har det varit tydligt att dessa går bortom överföring av information och även rymmer koordination mellan talare, retorik (till exempel hur en talare väljer att karaktärisera en händelse) och poetiska hänsyn. För dessa funktioner så krävs det en talare och en åhörare, inte bara en avsändare och en mottagare.

När det gäller Chat GPT så betraktar vi den som en talare, men den är bara en talare till namnet. Den har till exempel inte förmåga att på egen hand ge uttryck för en ståndpunkt eller en identitet. Den kan inte heller få en användare att utföra handlingar (språkliga eller utomspråkliga) eftersom den inte förstår skillnaden mellan beskrivning och utförande. Den har inte heller någon egen uppfattning om varför vissa yttranden ”låter bättre” än andra och varför vissa uttryck är att föredra framför andra i vissa situationer.

En avgörande komponent saknas alltså för att Chat GPT ska kunna betraktas som en riktig talare: Det finns ingen bakom skärmen. Det verkar som att det finns en talare där, men det gör det inte.

Sociologen Erving Goffman formulerade vad som räknas som en talare utifrån tre roller som han kallade uttalare (animator), författare (author) och ansvarig (principal). En nyhetsuppläsare har rollen av att vara uttalare av de nyheter som ska förmedlas i tv eller radio. Vanligtvis står en redaktion som författare av dessa nyheter och ibland ingår nyhetsuppläsaren i redaktionen. I så fall är hen även att betrakta som (med)författare utöver rollen som uttalare.

Om nyhetsuppläsaren håller sig till manus, så räknas dock aldrig denna som ansvarig för de uttalade nyheterna. Det är alltid den ansvariga utgivaren (till exempel Sveriges Television) som hålls ansvarig för de nyheter som förmedlas och om det skulle uppstå en kontrovers kring innehållet, så är det den ansvariga utgivaren som får delta i en eventuell debatt kring redaktionella val – och inte nyhetsuppläsaren.

En nyhetsuppläsare är alltså bara delvis en talare eftersom denna inte har något ansvar för det som sägs. Det har nyhetsuppläsaren gemensamt med Chat GPT – för hur sofistikerade texter applikationen än producerar (alltid på direkt uppmaning av en användare eller läsare), så kan den aldrig hållas ansvarig för innehållet. Olika restriktioner gällande vad Chat GPT får säga och inte säga – det går till exempel inte att få den att sprida direkt rasistiska eller homofoba yttranden – är inskrivna av programmerare; dom är inte formulerade av Chat GPT.

”Chat GPT kan varken stå till svars för vad den säger eller vara sanningsenlig”

Människor förväntas i normalfallet kunna stå till svars för vad dom påstår. En del skulle även hävda att vi förväntas vara sanningsenliga, även om en sådan förväntan har försvagats på sistone – åtminstone om man tar med den politiska debatten i beräkningen. Chat GPT kan varken stå till svars för vad den säger eller vara sanningsenlig. Den vet nämligen inte vad som är sant eller falskt, bara vad andra hävdar är sant eller falskt. Chat GPT saknar erfarenheter bortom insamlingen av andras texter och har därför ingen möjlighet att förankra texten den producerar utifrån detta i något annat än hur den kan förhållas till andra texter och hur väl den passar en användare.

Det språkliga utbytet mellan Chat GPT och en användare kan inte heller likställas med ett samtal mellan två människor av den enkla anledningen att den ena samtalspartnern är en maskin och den andra är en människa. Det finns nämligen inget språk i egentlig mening som har utvecklats för att användas mellan två olika arter. Vi kan instruera datorer med hjälp av kod, och vi kan kommunicera med andra djurarter på ett ibland ganska sofistikerat sätt, men dom flesta lingvister skulle tveka att likställa sådan kommunikation med språkanvändning.

Så länge det är riktiga människor som interagerar med Chat GPT kan vi inte få en tydlig bild av hur Chat GPT är som språkanvändare. Verkliga talare kompenserar nämligen för andra talares tillkortakommanden och läser in det som behövs för att göra ett yttrande begripligt. Vissa lingvister har till och med föreslagit att språkets uppkomst är att likställa med utvecklandet av ett verktyg för social sammanhållning. Vilka användningar vi än tänker oss för Chat GPT, så är social sammanhållning inte en av dom. För att sociala hänsyn ska vara en del av Chat GPT:s repertoar – och inte programmerarnas – så måste Chat GPT betrakta sig själv som en social aktör, alltså någon som har en relation till andra och som har ett syfte som tar hänsyn till dessa relationer.

Är då inte Chat GPT bara en talmaskin, precis som andra typer av robotar och maskiner som är tränade att utföra en uppgift? En ”ande i flaskan” som kan uppfylla (vissa) önskningar, men som till skillnad från anden i flaskan inte vill bli fri? Är det inte så att vi än en gång förtrollas av språket som det slutgiltiga beviset för mänsklig eller artificiell intelligens, när det egentligen handlar om en, förvisso sofistikerad och komplicerad, reproduktion av verkliga människors tal?

För att artificiell medvetenhet ska kunna påvisas måste Chat GPT utgå från en självuppfattning i det språkliga utbytet med andra. Språket är ett oerhört kraftfullt kommunikationsverktyg, men att det skulle kunna ge upphov till ett medvetet ”jag” utan andra erfarenheter av världen än den text som den har tillgång till är en orimlig förväntan.

”Som vanligt är det människor som utgör det främsta hotet mot andra människor”

En applikation som Chat GPT har potentialen att användas som ett verktyg och kanske som ett vapen, men bara av dess användare, inte av applikationen själv. Som vanligt är det människor som utgör det främsta hotet mot andra människor, och som svar på frågan om när Chat GPT blir medveten så är min gissning att den inte blir det inom en överskådlig framtid; kanske aldrig. Det krävs något annat än att ha tillgång till enorma mängder text och vara bra på att förutse vad nästa ord är för att skapa ett jag som vill kommunicera med andra.

Henrik Bergqvist är docent och lektor vid Institutionen för filosofi, lingvistik och vetenskapsteori vid Göteborgs universitet.

Chat GPT är baserad på generativ AI

Den första versionen av chattroboten Chat GPT lanserades i november 2022. Den använder sig av generativ AI för att bland annat besvara frågor, författa texter, komma med olika typer av förslag och samtala på olika språk. Chat GPT kan till exempel blixtsnabbt generera olika typer av texter – allt från forskningsöversikter och faktasammanställningar till krönikor och kåserier. Den som lär sig att prompta – att skriva träffsäkra instruktioner – kan därför ha stor nytta av verktyget. Men det är inte helt pålitligt. Det Chat GPT med självsäker ton presenterar som sanningar kan i själva verket vara rena påhitt. Den har varken medvetande eller omdöme och kan därför komma med felaktiga uppgifter. Chat GPT förutsäger vad svaret bör vara utifrån allt material som den tränats på – men ibland hamnar den snett och presenterar felaktigheter som fakta när sannolikhetskalkylerna leder fel. Chat GPT skulle till exempel kunna påstå att Astrid Lindgren skrev Röda rummet och att August Strindberg skrev Pippi Långstrump utan att ha förmågan att reflektera över att det inte stämmer.

En rad mediehus har börjat använda chattrobotar i det redaktionella arbetet. Några svenska bokförlag har också börjat utnyttja chattrobotar för översättning av litteratur. I regel granskas resultatet innan det publiceras.

Genomslaget för Chat GPT och andra chattrobotar har redan tvingat skolan, högskolor, universitet och andra utbildningsinstitutioner att se över olika moment eftersom det kan vara mycket svårt att se om elever och studenter har tagit hjälp av generativ AI för att skriva uppsatser och andra inlämningsuppgifter.

När filosofen och kognitionsforskaren David Chalmers senaste bok Virtuella världar släpptes anordnades en paneldebatt på Lilla Cirkus i Stockholm. Där diskuterades några av bokens centrala teman, nämligen artificiella och fysiska världar, samt mänskligt och artificiellt medvetande. I samtalet framgick att företrädare för både industri och forskning är förvånade över hur snabbt en AI-applikation som Chat GPT har utvecklats och hur väl den kan generera mänskligt språk.

Vid det här laget har nog många hört talas om Chat GPT:s förmåga att snabbt generera olika typer av texter, men också att en effektiv användning kräver träffsäkra instruktioner av användaren. Kravet på faktagranskning är också stort eftersom applikationen av olika skäl inte alltid framställer sanningsenliga fakta.

Då Chat GPT bygger på vad som kallas artificiell intelligens, AI, så har den senaste tidens snabba utveckling gjort att förutsägelser tidigarelagts gällande hur snart AI kan tillskrivas medvetande. David Chalmers spekulerade under samtalet att en medveten AI skulle kunna vara möjlig redan inom 20 år, i kontrast mot hans tidigare förutsägelser som har varit mycket mer försiktiga.

Panelen på Lilla Cirkus diskuterade de politiska och sociala implikationerna av ett artificiellt medvetande, men frågan om vad som faktiskt kan räknas som ett sådant lämnades mestadels obesvarad. Och här står språkförmågan i centrum.

Även om det till viss del är oklart hur en applikation som Chat GPT faktiskt går till väga för att kunna producera människoliknande tal i skrift, så pekar den snabba utvecklingen på att förmågan att förutse nästa ord är avgörande för applikationens framgång. En paneldeltagare föreslog att det kanske inte behövs mer än så för att kunna producera språk, och att en förmåga att förutse vad som kommer härnäst skulle gå att likställa med intelligens och medvetande, både för människor och AI.

Men det finns problem med den synen på artificiell intelligens. Några av dessa problem har att göra med hur vi definierar språk och vilket förhållande språket kan tänkas ha till medvetandet. Det är uppenbarligen möjligt att tala – i bemärkelsen att producera språkliga yttranden i form av text – utan att vara medveten. Det är vad Chat GPT gör. Den kan producera oändliga mängder text utan att egentligen förstå vad den själv säger.

Men det är också möjligt att vara medveten utan att kunna tala. Olika beskrivningar av komaliknande tillstånd där patienten är medveten men oförmögen att kommunicera är ett exempel på detta. Vi vill också veta om djur är medvetna. Vi har goda skäl att tro det, men eftersom de inte kan tala så har vi svårt att bedöma om de är det.

Problemet med båda scenarierna är att det är svårt att bedöma graden av medvetenhet utifrån några andra parametrar än språklig kommunikation. Graden av medvetenhet hos en komatös patient går bara att bedöma efter att patienten har kommit ur koman och kan berätta om sin upplevelse. Språkförmåga kan därmed inte likställas med medvetenhet även om medvetenhet bara kan bedömas med hjälp av språk. Trots detta så är språkförmågan en avgörande komponent i debatten om AI:s eventuella medvetenhet och vilka konsekvenser det kommer ha för oss människor.

”Ett sofistikerat verktyg för att uppdatera vår egen och andras kunskap om världen”

Vad är då språket, som har en sådan central roll i debatten om artificiell intelligens och medvetande? Det finns flera modeller för hur språket kan definieras, men den dominerande skulle kunna beskrivas som informationsöverföringsmodellen. Den beskriver språk som ett sofistikerat verktyg för att uppdatera vår egen och andras kunskap om världen och för att kunna redogöra för våra upplevelser gentemot våra artfränder. Samma modell kan även appliceras på andra djurarters kommunikation – även om språk alltid framhålls som en speciell form av kommunikation som är reserverad för människor.

Enligt informationsöverföringsmodellen kan yttranden delas in i grammatiska och ogrammatiska yttranden, det vill säga yttranden som betyder något och sådana som inte gör det. Att Chat GPT är så bra på att producera yttranden som betyder något (det vill säga grammatiska yttranden) är det som fascinerar oss och det som gör oss benägna att tillskriva applikationen någon form av intelligens och – om några år – kanske även medvetande.

Språk som informationsöverföringsverktyg är dock inte den enda möjliga modellen för att definiera språk. En sådan modell har dessutom flera tillkortakommanden som gör att man kan ifrågasätta dess giltighet. Dom flesta lingvister anser nämligen att språk är mer än informationsöverföring.

Om man antar en funktionalistisk syn på språk där form följer funktion, så är informationsöverföring bara en av flera språkfunktioner. Helt kort så innebär en funktionalistisk syn på språk att språkanvändning ger upphov till språkstruktur, snarare än att sådan struktur skulle vara förprogrammerad i det mänskliga psyket. Ända sedan lingvistpionjären Roman Jakobson presenterade sin syn på språkets funktioner på 1960-talet, så har det varit tydligt att dessa går bortom överföring av information och även rymmer koordination mellan talare, retorik (till exempel hur en talare väljer att karaktärisera en händelse) och poetiska hänsyn. För dessa funktioner så krävs det en talare och en åhörare, inte bara en avsändare och en mottagare.

När det gäller Chat GPT så betraktar vi den som en talare, men den är bara en talare till namnet. Den har till exempel inte förmåga att på egen hand ge uttryck för en ståndpunkt eller en identitet. Den kan inte heller få en användare att utföra handlingar (språkliga eller utomspråkliga) eftersom den inte förstår skillnaden mellan beskrivning och utförande. Den har inte heller någon egen uppfattning om varför vissa yttranden ”låter bättre” än andra och varför vissa uttryck är att föredra framför andra i vissa situationer.

En avgörande komponent saknas alltså för att Chat GPT ska kunna betraktas som en riktig talare: Det finns ingen bakom skärmen. Det verkar som att det finns en talare där, men det gör det inte.

Sociologen Erving Goffman formulerade vad som räknas som en talare utifrån tre roller som han kallade uttalare (animator), författare (author) och ansvarig (principal). En nyhetsuppläsare har rollen av att vara uttalare av de nyheter som ska förmedlas i tv eller radio. Vanligtvis står en redaktion som författare av dessa nyheter och ibland ingår nyhetsuppläsaren i redaktionen. I så fall är hen även att betrakta som (med)författare utöver rollen som uttalare.

Om nyhetsuppläsaren håller sig till manus, så räknas dock aldrig denna som ansvarig för de uttalade nyheterna. Det är alltid den ansvariga utgivaren (till exempel Sveriges Television) som hålls ansvarig för de nyheter som förmedlas och om det skulle uppstå en kontrovers kring innehållet, så är det den ansvariga utgivaren som får delta i en eventuell debatt kring redaktionella val – och inte nyhetsuppläsaren.

En nyhetsuppläsare är alltså bara delvis en talare eftersom denna inte har något ansvar för det som sägs. Det har nyhetsuppläsaren gemensamt med Chat GPT – för hur sofistikerade texter applikationen än producerar (alltid på direkt uppmaning av en användare eller läsare), så kan den aldrig hållas ansvarig för innehållet. Olika restriktioner gällande vad Chat GPT får säga och inte säga – det går till exempel inte att få den att sprida direkt rasistiska eller homofoba yttranden – är inskrivna av programmerare; dom är inte formulerade av Chat GPT.

”Chat GPT kan varken stå till svars för vad den säger eller vara sanningsenlig”

Människor förväntas i normalfallet kunna stå till svars för vad dom påstår. En del skulle även hävda att vi förväntas vara sanningsenliga, även om en sådan förväntan har försvagats på sistone – åtminstone om man tar med den politiska debatten i beräkningen. Chat GPT kan varken stå till svars för vad den säger eller vara sanningsenlig. Den vet nämligen inte vad som är sant eller falskt, bara vad andra hävdar är sant eller falskt. Chat GPT saknar erfarenheter bortom insamlingen av andras texter och har därför ingen möjlighet att förankra texten den producerar utifrån detta i något annat än hur den kan förhållas till andra texter och hur väl den passar en användare.

Det språkliga utbytet mellan Chat GPT och en användare kan inte heller likställas med ett samtal mellan två människor av den enkla anledningen att den ena samtalspartnern är en maskin och den andra är en människa. Det finns nämligen inget språk i egentlig mening som har utvecklats för att användas mellan två olika arter. Vi kan instruera datorer med hjälp av kod, och vi kan kommunicera med andra djurarter på ett ibland ganska sofistikerat sätt, men dom flesta lingvister skulle tveka att likställa sådan kommunikation med språkanvändning.

Så länge det är riktiga människor som interagerar med Chat GPT kan vi inte få en tydlig bild av hur Chat GPT är som språkanvändare. Verkliga talare kompenserar nämligen för andra talares tillkortakommanden och läser in det som behövs för att göra ett yttrande begripligt. Vissa lingvister har till och med föreslagit att språkets uppkomst är att likställa med utvecklandet av ett verktyg för social sammanhållning. Vilka användningar vi än tänker oss för Chat GPT, så är social sammanhållning inte en av dom. För att sociala hänsyn ska vara en del av Chat GPT:s repertoar – och inte programmerarnas – så måste Chat GPT betrakta sig själv som en social aktör, alltså någon som har en relation till andra och som har ett syfte som tar hänsyn till dessa relationer.

Är då inte Chat GPT bara en talmaskin, precis som andra typer av robotar och maskiner som är tränade att utföra en uppgift? En ”ande i flaskan” som kan uppfylla (vissa) önskningar, men som till skillnad från anden i flaskan inte vill bli fri? Är det inte så att vi än en gång förtrollas av språket som det slutgiltiga beviset för mänsklig eller artificiell intelligens, när det egentligen handlar om en, förvisso sofistikerad och komplicerad, reproduktion av verkliga människors tal?

För att artificiell medvetenhet ska kunna påvisas måste Chat GPT utgå från en självuppfattning i det språkliga utbytet med andra. Språket är ett oerhört kraftfullt kommunikationsverktyg, men att det skulle kunna ge upphov till ett medvetet ”jag” utan andra erfarenheter av världen än den text som den har tillgång till är en orimlig förväntan.

”Som vanligt är det människor som utgör det främsta hotet mot andra människor”

En applikation som Chat GPT har potentialen att användas som ett verktyg och kanske som ett vapen, men bara av dess användare, inte av applikationen själv. Som vanligt är det människor som utgör det främsta hotet mot andra människor, och som svar på frågan om när Chat GPT blir medveten så är min gissning att den inte blir det inom en överskådlig framtid; kanske aldrig. Det krävs något annat än att ha tillgång till enorma mängder text och vara bra på att förutse vad nästa ord är för att skapa ett jag som vill kommunicera med andra.

Henrik Bergqvist är docent och lektor vid Institutionen för filosofi, lingvistik och vetenskapsteori vid Göteborgs universitet.

Chat GPT är baserad på generativ AI

Den första versionen av chattroboten Chat GPT lanserades i november 2022. Den använder sig av generativ AI för att bland annat besvara frågor, författa texter, komma med olika typer av förslag och samtala på olika språk. Chat GPT kan till exempel blixtsnabbt generera olika typer av texter – allt från forskningsöversikter och faktasammanställningar till krönikor och kåserier. Den som lär sig att prompta – att skriva träffsäkra instruktioner – kan därför ha stor nytta av verktyget. Men det är inte helt pålitligt. Det Chat GPT med självsäker ton presenterar som sanningar kan i själva verket vara rena påhitt. Den har varken medvetande eller omdöme och kan därför komma med felaktiga uppgifter. Chat GPT förutsäger vad svaret bör vara utifrån allt material som den tränats på – men ibland hamnar den snett och presenterar felaktigheter som fakta när sannolikhetskalkylerna leder fel. Chat GPT skulle till exempel kunna påstå att Astrid Lindgren skrev Röda rummet och att August Strindberg skrev Pippi Långstrump utan att ha förmågan att reflektera över att det inte stämmer.

En rad mediehus har börjat använda chattrobotar i det redaktionella arbetet. Några svenska bokförlag har också börjat utnyttja chattrobotar för översättning av litteratur. I regel granskas resultatet innan det publiceras.

Genomslaget för Chat GPT och andra chattrobotar har redan tvingat skolan, högskolor, universitet och andra utbildningsinstitutioner att se över olika moment eftersom det kan vara mycket svårt att se om elever och studenter har tagit hjälp av generativ AI för att skriva uppsatser och andra inlämningsuppgifter.